语言模型

、扩散模型)已显示出卓越的性能,但它们需要大量的计算资源。为了让这些模型更易于使用,提高它们的效率至关重要。

韩松

将深入解读生成式大模型时代的「AI 计算的模型压缩与加速技术」。

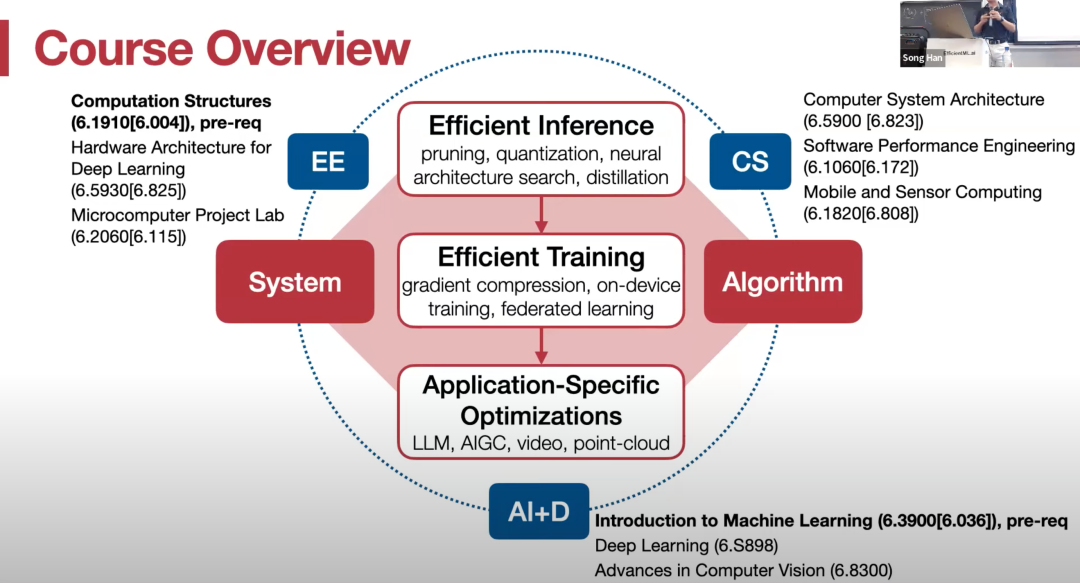

深度学习

计算》。概括来说,这门课程将介绍高效的

人工智能

计算技术,以便在资源有限的设备上实现强大的

深度学习

应用。

剪枝

、

量化

、神经架构搜索、分布式训练、数据 / 模型并行化、梯度压缩和设备微调,还介绍了针对大

语言模型

、扩散模型、视频识别和点云的特定应用加速技术,并涵盖了

量子机器学习

的相关主题。此外,学生将获得在笔记本电脑上部署大型

语言模型

(如 LLaMA 2)的实践经验。

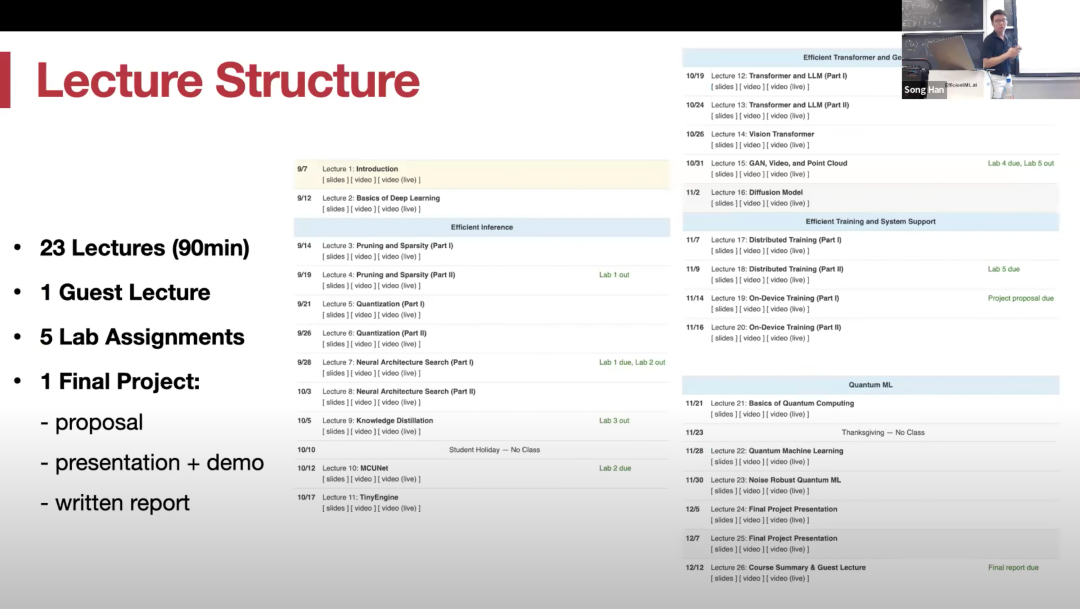

课程大纲

规划

如下图所示:

神经网络

基础,第三、四章是

剪枝

和稀疏性,第五章是

量化

。

讲师介绍

韩松

主讲,并由他的两位博士生林吉和蔡涵担任助教。

韩松

在斯坦福大学获得博士学位,2018 年加入 MIT,现为电子工程科学系副教授,研究广泛涉足

深度学习

和计算机体系结构。

韩松

团队在硬件

感知

神经架构搜索(once-for-all network)方面的工作使用户能够设计、优化、缩小

人工智能

模型,并将其部署到资源受限的硬件设备上。

剪枝

和

量化

在内的「

深度压缩

」(Deep Compression)技术。

推理引擎

」(Efficient Inference Engine,EIE),首次将

权重

稀疏性引入现代 AI 芯片,并影响了英伟达公司带有稀疏

张量

核心的安培 GPU 架构。

韩松

博士的两次创业,均获得了 AI 领域的高度关注。

韩松

与同为

清华大学

毕业的汪玉、姚颂联合创立了

深鉴科技

(DeePhi Tech),其核心技术之一为

神经网络

压缩算法,随后

深鉴科技

被美国半导体公司赛灵思收购。

韩松

与吴迪、毛慧子共同成立 AI

边缘计算

公司 OmniML,旨在通过创建

深度学习

模型来弥合 AI 应用程序与边缘上的各种设备之间的差距,从而提高 AI 的速度、准确性和效率。今年,该公司被英伟达收购。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...